В сети появляется все больше изображений, сгенерированных искусственным интеллектом, на которых изображены дети или жертвы насилия. Как сообщает The Guardian, эти картинки активно используют даже крупные международные благотворительные и медицинские организации в своих социальных кампаниях, что вызвало волну возмущения среди экспертов.

Что происходит

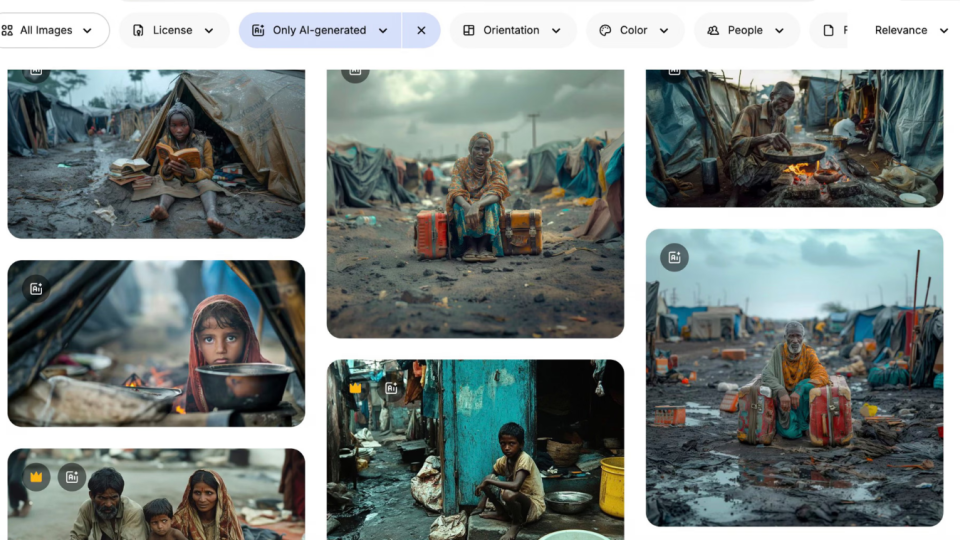

Искусственный интеллект массово генерирует «реалистичные» фото людей в нищете, детей с пустыми тарелками или девочек в слезах, которые якобы пережили насилие. Такие изображения продаются на крупных стоковых платформах и используются в благотворительных постах и видеороликах.

Исследователь Арсений Аленичев из Института тропической медицины в Антверпене собрал более сотни таких примеров и назвал это явление «poverty porn 2.0» — эксплуатацией образа бедности в новой, цифровой форме.

«Эти картинки воспроизводят худшие стереотипы — темнокожие дети в грязи, избитые лица, старые лачуги. Это не реальные люди, но они формируют у зрителей представление о „бедном мире“», — отметил эксперт.

Почему это опасно

Специалисты подчеркивают, что подобные фото распространяют расовые и социальные предрассудки. По словам Ноа Арнольда из швейцарской организации Fairpicture, которая продвигает этическое использование изображений в медиа, «организации начали прибегать к синтетическим изображениям, потому что это дешево и не требует получения согласия на съемку».

«Миллионы евро урезали из бюджетов НПО, и теперь вместо фотографов они используют нейросети», — пояснил Арнольд.

Эксперты предупреждают: фейковые изображения проникают в глобальные базы данных и могут впоследствии использоваться для обучения новых ИИ-моделей, что лишь усилит предвзятость.

Как реагируют компании и организации

На платформах стоковых фото уже десятки таких ИИ-изображений, которые можно купить за несколько десятков долларов. Представитель Freepik признал проблему, но заявил, что «невозможно контролировать все запросы пользователей».

Ранее подобные материалы использовали даже международные организации. В 2023 году нидерландское подразделение Plan International опубликовало видео против детских браков с использованием ИИ-изображений, а ООН создала ролик о сексуальном насилии в конфликтах — тоже с фейковыми сценами. После критики видео было удалено.

Представитель ООН пояснил, что «видео было создано с использованием новой технологии, которая быстро развивается, но оно не соответствовало этическим стандартам и могло искажать информацию».

Что говорят специалисты

Коммуникационный консультант Кейт Кардол назвала такие практики тревожными: «Мы годами боролись за достойное изображение людей, живущих в бедности. Теперь эту борьбу придется вести и против вымышленных образов».

Подписывайтесь на наш Тelegram-канал t.me/sudua и на Google Новости SUD.UA, а также на наш VIBER, страницу в Facebook и в Instagram, чтобы быть в курсе самых важных событий.